زمانی که یک وبسایت راهاندازی میکنید، تنها کاربران انسانی به صفحات سایت شما وارد نمیشوند. در کنار آنها، رباتهای خزنده نیز به صفحات مختلف سر میزنند و اطلاعات را جمعآوری، پردازش و ایندکس میکنند. برخی از این رباتها، مثل ربات گوگل، در بهبود رتبهبندی سایت شما در نتایج جستجو نقش دارند. اما ممکن است برخی از رباتها به صورت غیرضروری به بخشهایی از سایت شما که نباید برای آنها قابل مشاهده باشد دسترسی پیدا کنند و حتی باعث ایجاد بار اضافی روی سرور شوند.

در چنین شرایطی، شما به ابزاری نیاز دارید که بتوانید کنترل دقیقی بر دسترسی این رباتها به سایت خود داشته باشید. فایل Robots.txt دقیقاً این کار را انجام میدهد. این فایل متنی ساده و کاربردی، با تعیین قوانین خاص به رباتها میگوید که کدام صفحات باید کرال شوند و کدام قسمتها باید از دید آنها مخفی بماند.

چطور فایل Robots.txt میتواند به بهینهسازی سایت کمک کند؟

در دنیای وب، رباتهای موتور جستجو به طور مداوم در حال خزیدن و بررسی سایتها هستند تا جدیدترین اطلاعات را شناسایی کرده و آنها را ایندکس کنند. این فرآیند که به آن Crawling گفته میشود، موجب نمایش بهتر صفحات در نتایج جستجو میشود. اما در برخی مواقع ممکن است بخواهید برخی از صفحات سایت شما از دسترسی رباتها خارج شوند تا از ایندکس شدن آنها جلوگیری کنید. در این شرایط، فایل Robots.txt ابزاری است که میتواند به شما کمک کند.

Robots.txt یک فایل متنی ساده است که میتواند به طور دقیق مشخص کند کدام صفحات سایت برای رباتها قابل دسترسی هستند و کدام قسمتها باید از آنها مخفی بمانند. این فایل بخشی از پروتکل «Robots Exclusion Protocol» (REP) است که استانداردهایی برای چگونگی دسترسی رباتها به صفحات، ایندکس شدن آنها و دنبال کردن یا نکردن لینکها (Follow و NoFollow) تعیین میکند.

اهمیت فایل Robots.txt برای کنترل دسترسی رباتها

وبمسترها و مدیران سایتها معمولاً از فایل Robots.txt برای اعمال کنترل بیشتر بر نحوه دسترسی رباتها به سایت خود استفاده میکنند. این فایل نه تنها به کاهش بار سرور کمک میکند، بلکه به شما این امکان را میدهد که بخشهایی از سایت خود را که نمیخواهید توسط رباتها خزیده شوند، از دید آنها پنهان کنید. در نتیجه، این فایل میتواند در بهینهسازی عملکرد سایت و حفظ منابع سرور شما تأثیر زیادی داشته باشد.

نحوه عملکرد فایل Robots.txt

هنگامی که رباتهای گوگل یا سایر موتورهای جستجو به سایت شما سر میزنند، از دو روش اصلی برای دسترسی به صفحات استفاده میکنند:

- از طریق لینکها

- از طریق فایل Robots.txt

این دو روش باعث میشوند که رباتها تنها به صفحات مشخصی دسترسی پیدا کنند و از دسترسی به بخشهای غیرضروری یا حساس جلوگیری کنند. به همین دلیل، تنظیم صحیح فایل Robots.txt برای بهینهسازی سایت شما از اهمیت ویژهای برخوردار است.

این فایل به شما کمک میکند تا تجربه کاربری بهتری را فراهم کنید، بدون اینکه نگران دسترسی رباتهای خزنده به اطلاعات حساس یا غیرضروری باشید.

بررسی سایت از طریق لینکها

در فرآیند بررسی سایت، رباتهای گوگل به طور خودکار از طریق لینکهای داخلی موجود در سایت حرکت میکنند. این رباتها با دنبال کردن لینکهایی که در صفحات مختلف سایت از جمله صفحه اصلی، منوها، و دیگر بخشها قرار دارند، به شناسایی صفحات جدید و تغییرات بهروزرسانیشده میپردازند. به محض اینکه رباتها وارد سایت میشوند، از طریق این لینکها به صفحات مختلف هدایت میشوند. اگر این صفحات خود دارای لینکهای داخلی دیگری باشند، رباتها بهطور خودکار آنها را دنبال کرده و از این طریق تصمیم میگیرند که کدام صفحات برای ایندکس شدن مناسب هستند. این فرآیند به رباتها این امکان را میدهد تا تمام بخشهای مهم و مرتبط سایت شما را شناسایی کرده و در نتایج جستجو به نمایش بگذارند.

بررسی سایت از طریق فایل Robots.txt

زمانی که سایت شما دارای فایل Robots.txt باشد، رباتهای گوگل ابتدا این فایل را بررسی میکنند تا ببینند که چه دستوراتی برای آنها تعیین شده است. این فایل بهطور دقیق مشخص میکند که کدام بخشهای سایت باید توسط رباتها کراول یا خزیده شوند و کدام صفحات باید از دسترس آنها خارج باشند. به عبارت دیگر، فایل Robots.txt این امکان را فراهم میکند که شما بهطور مستقیم کنترل کنید که کدام صفحات باید ایندکس شوند و کدامیک نباید در نتایج جستجو نمایش داده شوند. استفاده صحیح و بهجا از این فایل میتواند به بهینهسازی عملکرد سایت کمک کرده و از ایندکس شدن صفحات غیرضروری جلوگیری کند.

اهمیت استفاده از فایل Robots.txt

فایل Robots.txt یکی از ابزارهای حیاتی برای مدیریت نحوه دسترسی رباتهای موتورهای جستجو به سایت شما است. تنظیم صحیح و دقیق این فایل میتواند تأثیر زیادی بر عملکرد سایت داشته باشد و به شما کمک کند تا صفحات مدنظر خود را بهطور صحیح در نتایج جستجو نمایش دهید. در این بخش، به بررسی دلایل اصلی اهمیت استفاده از فایل Robots.txt خواهیم پرداخت.

1. جلوگیری از کنیبالیزیشن (Cannibalization)

کنیبالیزیشن زمانی رخ میدهد که دو یا چند صفحه مشابه از سایت شما بهطور همزمان در نتایج جستجو رتبه میگیرند، که در نتیجه رقابت داخلی میان صفحات سایت ایجاد میشود. این رقابت میتواند باعث کاهش نرخ کلیک (CTR) و کاهش ترافیک سایت شود. با استفاده از فایل Robots.txt، شما قادر خواهید بود صفحاتی که نباید ایندکس شوند را مشخص کنید و از بروز این مشکل جلوگیری نمایید. به این ترتیب، میتوانید مانع از رقابت داخلی در سایت خود شوید و عملکرد بهتری در جلب توجه کاربران داشته باشید.

2. جلوگیری از ایندکس شدن فایلهای خاص

گاهی اوقات ممکن است بخواهید برخی از فایلها مانند PDFها، تصاویر، ویدئوها یا اسناد آموزشی در نتایج جستجو ایندکس نشوند. این کار میتواند بهویژه برای سایتهایی که محتوای آموزشی یا اشتراکی ارائه میدهند، حائز اهمیت باشد. با استفاده از تنظیمات صحیح فایل Robots.txt، میتوانید از ایندکس شدن این نوع فایلها جلوگیری کنید و از اینکه محتوای غیرضروری در نتایج جستجو نمایش داده شود، جلوگیری کنید.

3. کنترل نمایش برخی صفحات در نتایج جستجو

برخی صفحات خاص سایت شما مانند صفحات “درباره ما” یا “تماس با ما” معمولاً نیازی به ایندکس شدن در موتورهای جستجو ندارند. بهعنوان مثال، ممکن است شما ترجیح دهید این صفحات را از نمایش در نتایج جستجو حذف کنید تا تمرکز اصلی ایندکس روی محتوای اصلی سایت شما باقی بماند. با تنظیم مناسب فایل Robots.txt، میتوانید دسترسی رباتها به این صفحات خاص را محدود کنید و از ایندکس شدن آنها جلوگیری نمایید.

4. مدیریت ترافیک رباتها و بهینهسازی عملکرد سایت

یکی از مشکلاتی که ممکن است در سایتهای پر ترافیک و یا سایتهایی با هاست محدود پیش بیاید، ایجاد فشار اضافی بر سرور به دلیل دسترسی بیمحدود رباتها است. در صورتی که رباتها بهطور مداوم صفحات مختلف سایت را کراول کنند، این موضوع میتواند موجب کاهش سرعت سایت و تجربه کاربری ضعیفتر شود. برای جلوگیری از این مشکلات، شما میتوانید با تنظیمات دقیق فایل Robots.txt، نرخ خزش رباتها را کنترل کرده و از ایجاد بار اضافی بر روی سرور جلوگیری کنید. این کار همچنین میتواند باعث بهبود عملکرد سایت شما در جستجوها و به ویژه در نمایش سایت در Google Discover شود.

با استفاده صحیح از فایل Robots.txt، شما میتوانید دسترسی رباتها به سایت خود را بهینه کرده و همزمان از ایندکس شدن صفحات غیرضروری و ایجاد فشار اضافی بر سرور جلوگیری کنید. این ابزار به شما کمک میکند تا منابع سایت خود را بهطور مؤثرتر مدیریت کنید و تجربه کاربری بهتری را برای بازدیدکنندگان سایت خود فراهم نمایید.

انواع دستورات موجود در فایل Robots.txt

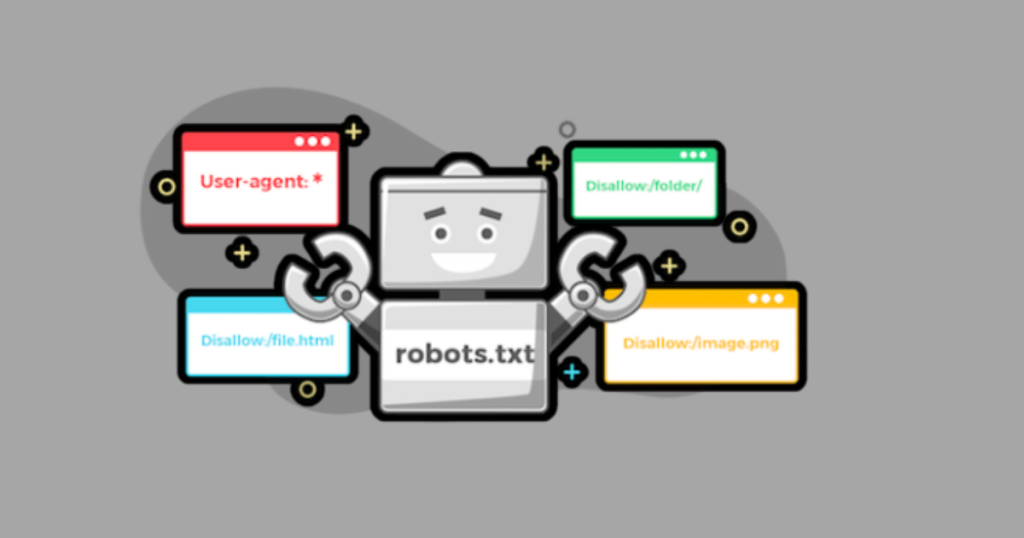

فایل Robots.txt ابزاری است که به وبمسترها این امکان را میدهد تا دسترسی رباتهای موتور جستجو به بخشهای مختلف سایت خود را بهطور دقیق مدیریت کنند. این فایل شامل مجموعهای از دستورات است که کنترل نحوه و میزان خزیدن رباتها را فراهم میکند.

1. دستور User-agent

دستور User-agent مشخص میکند که کدام رباتها باید دستورات فایل Robots.txt را دنبال کنند. این دستور میتواند بهصورت عمومی برای تمام رباتها یا برای یک ربات خاص اعمال شود.

فرمت استفاده:

makefileCopyEditUser-agent: *

این دستور به تمامی رباتها اجازه میدهد که فایل Robots.txt را بخوانند.

makefileCopyEditUser-agent: Googlebot

این دستور فقط برای ربات گوگل اعمال میشود.

2. دستور Disallow

دستور Disallow به شما این امکان را میدهد که مشخص کنید رباتها اجازه دسترسی به کدام بخشهای سایت را ندارند. این دستور برای جلوگیری از خزیدن رباتها در قسمتهایی از سایت که برای آنها باید محدود شود، استفاده میشود.

فرمت استفاده:

makefileCopyEditUser-agent: *Disallow: /private

در این مثال، تمامی رباتها از دسترسی به پوشه private/ منع میشوند.

makefileCopyEditUser-agent: GooglebotDisallow: /admin

در این دستور، ربات گوگل از دسترسی به پوشه admin/ جلوگیری میشود.

3. دستور Allow

دستور Allow به شما این امکان را میدهد که برخی از فایلها یا صفحات داخل پوشههای ممنوعه را برای رباتها قابل دسترس کنید. به عبارت دیگر، با استفاده از این دستور میتوانید دسترسی خاصی به رباتها در بخشهایی که به طور معمول مسدود هستند، فراهم کنید.

فرمت استفاده:

makefileCopyEditUser-agent: *Disallow: /imagesAllow: /images/logo.jpg

در این مثال، رباتها اجازه ورود به پوشه images/ را ندارند، اما فایل logo.jpg که در این پوشه قرار دارد، به راحتی قابل خزیدن خواهد بود.

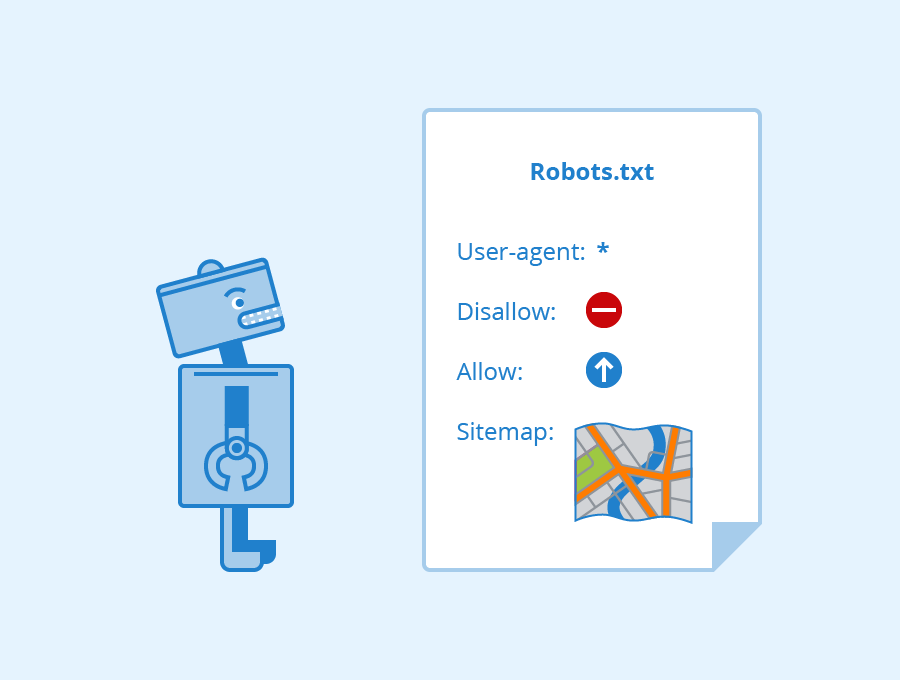

4. دستور Sitemap

دستور Sitemap به موتورهای جستجو کمک میکند تا نقشه سایت (Sitemap.xml) شما را پیدا کنند و بتوانند بهراحتی تمام صفحات سایت را ایندکس کنند. این دستور مسیر نقشه سایت شما را به رباتها نشان میدهد.

فرمت استفاده:

arduinoCopyEditSitemap: https://example.com/sitemap.xml

این دستور مسیر فایل Sitemap.xml را مشخص کرده و به رباتها اطلاع میدهد که از آن برای خزیدن و ایندکس کردن صفحات سایت استفاده کنند.

5. دستور Crawl-delay

دستور Crawl-delay تعیین میکند که رباتها باید بین هر درخواست چقدر صبر کنند تا از ایجاد فشار و بار اضافی روی سرور جلوگیری شود. این دستور بهویژه برای کنترل سرعت خزیدن رباتها و جلوگیری از مشکلات عملکردی سایت مفید است.

فرمت استفاده:

makefileCopyEditUser-agent: *Crawl-delay: 10

در این مثال، رباتها باید ۱۰ ثانیه بین هر درخواست صبر کنند. نکته قابل توجه این است که گوگل از دستور Crawl-delay پشتیبانی نمیکند و برای تنظیم سرعت خزیدن گوگل باید از Google Search Console استفاده کرد.

با استفاده صحیح از این دستورات در فایل Robots.txt، شما میتوانید بهطور مؤثری کنترل کنید که کدام بخشها از سایت شما برای رباتها قابل دسترسی باشند و کدام بخشها باید از دسترس آنها خارج شوند. این ابزار ساده اما قدرتمند به شما کمک میکند تا عملکرد سایت خود را بهینه کرده و از ایجاد مشکلاتی مانند فشار اضافی بر سرور یا ایندکس شدن محتوای غیرضروری جلوگیری کنید.

فایل Robots.txt کجای سایت قرار میگیرد؟

یافتن فایل robots.txt در هر وبسایتی کار سادهای است. برای مشاهده این فایل کافی است آدرس دامنه سایت را در مرورگر خود وارد کرده و در انتهای آن عبارت “/robots.txt” را اضافه کنید. به عنوان مثال، برای مشاهده فایل در یک سایت فرضی میتوانید به این آدرس مراجعه کنید:

arduinoCopyEdithttps://example.com/robots.txt

با وارد کردن این آدرس، شما بهراحتی میتوانید محتوای فایل robots.txt هر سایت را مشاهده کنید.

اگر قصد دارید فایل robots.txt را ویرایش کنید، باید بدانید که این فایل در روت (Root) سایت قرار دارد. برای دسترسی به فایل robots.txt در سایت خود، مراحل زیر را دنبال کنید:

- وارد هاست سایت خود شوید.

- به پوشه اصلی (Root Directory) سایت بروید.

- فایل robots.txt را پیدا کنید.

- پس از پیدا کردن فایل، میتوانید دستورات جدیدی اضافه کنید یا دستورات قبلی را تغییر دهید.

- بعد از ویرایش، فایل را ذخیره کنید.

بهترین روشهای بهینهسازی فایل Robots.txt برای سئو

برای استفاده مؤثر از فایل robots.txt و جلوگیری از بروز مشکلات مختلف، رعایت نکات زیر در بهینهسازی این فایل بسیار مهم است:

1. از مسدود نکردن صفحات مهم مطمئن شوید

قبل از ایجاد یا ویرایش فایل robots.txt، باید اطمینان حاصل کنید که صفحات مهم و ضروری سایت شما بهطور تصادفی مسدود نشدهاند. مسدود کردن صفحات کلیدی میتواند منجر به حذف آنها از فهرست نتایج موتورهای جستجو مانند گوگل شود.

2. دقت در لینکدهی به صفحات مسدود شده

زمانی که صفحهای را در فایل robots.txt با دستور Disallow مسدود میکنید، لینکهای داخلی این صفحه نیز توسط رباتها دنبال نخواهند شد، مگر اینکه آن صفحه از طریق لینکهای دیگر که برای موتور جستجو قابل مشاهده است، در دسترس باشد. در این حالت، محتوای لینکشده ممکن است به درستی ایندکس نشود، که میتواند تأثیر منفی بر سئو داشته باشد.

3. از robots.txt برای جلوگیری از نمایش اطلاعات حساس استفاده نکنید

اگر قصد دارید از نمایش اطلاعات حساس یا خصوصی در نتایج جستجو جلوگیری کنید، استفاده از فایل robots.txt گزینه مناسبی نیست. حتی با دستور Disallow، گوگل ممکن است همچنان این صفحات را ایندکس کند. در این موارد، استفاده از متا تگ noindex یا محافظت از صفحه با رمز عبور گزینههای بهتری هستند.

4. شناخت انواع User-agent در موتورهای جستجو

برخی از موتورهای جستجو از چندین User-agent برای اهداف مختلف استفاده میکنند. برای مثال، گوگل از Googlebot برای جستجوی ارگانیک و Googlebot-Image برای جستجوی تصاویر استفاده میکند. در حالی که معمولاً تمام رباتهای یک موتور جستجو از یک مجموعه قوانین پیروی میکنند، در صورت نیاز میتوانید برای هر ربات دستورات مجزا تعیین کنید.

5. بروزرسانی سریعتر فایل Robots.txt در گوگل

موتورهای جستجو فایل robots.txt را کش (Cache) کرده و معمولاً هر روز آن را بروزرسانی میکنند. اما اگر شما تغییراتی در فایل اعمال کردهاید و میخواهید سریعتر آن تغییرات در گوگل اعمال شود، میتوانید از طریق Google Search Console فایل جدید robots.txt را ارسال (Submit) کنید تا گوگل آن را زودتر بررسی کرده و به روز رسانی کند.

با رعایت این نکات، میتوانید به بهترین شکل ممکن از فایل robots.txt برای بهینهسازی سئو سایت خود استفاده کنید و مشکلاتی که ممکن است عملکرد سایت شما را تحت تاثیر قرار دهد، جلوگیری کنید.

آموزش گام به گام ساخت فایل Robots.txt

فایل robots.txt یک ابزار مهم و ساده است که به موتورهای جستجو دستور میدهد که کدام بخشهای سایت شما باید ایندکس شوند و کدام قسمتها باید از دید آنها مخفی بماند. در این مقاله، مراحل ساخت و تنظیمات ضروری این فایل را بررسی خواهیم کرد.

۱. ساختار و فرمت کلی فایل Robots.txt

فایل robots.txt از دستورات سادهای تشکیل میشود که مشخص میکند رباتهای موتور جستجو به کدام بخشهای سایت دسترسی دارند و کدام بخشها باید از دسترس آنها خارج شوند. در این فایل ابتدا باید نوع User-agent (ربات جستجو) را مشخص کنید و سپس با استفاده از دستورات Allow و Disallow دسترسیها را تنظیم کنید. به این مثال توجه کنید:

makefileCopyEditUser-Agent: *Allow: /wp-content/uploads/Disallow: /wp-content/plugins/Disallow: /readme.html

در این مثال:

- علامت * به این معنی است که این دستورات برای تمامی رباتهای جستجو اعمال میشود.

- دستور Allow اجازه میدهد رباتها به پوشه آپلودها (wp-content/uploads/) دسترسی داشته باشند.

- دستور Disallow دسترسی به پوشه پلاگینها (wp-content/plugins/) و فایل readme.html را محدود میکند.

۲. استفاده از robots.txt برای مدیریت دسترسی رباتها

اگر نمیخواهید موتورهای جستجو به تمام بخشهای سایت شما دسترسی پیدا کنند، میتوانید از فایل robots.txt برای کنترل دسترسیها استفاده کنید. بهعنوان مثال، اگر میخواهید برخی از دستهبندیهای سایت وردپرسی شما در نتایج جستجو ایندکس نشوند، میتوانید از افزونههای معروف مانند Yoast SEO برای تنظیم این دستورات بهره ببرید. علاوه بر این، میتوانید فایلهای خاصی مانند readme.html را از ایندکس شدن در نتایج جستجو جلوگیری کنید و دسترسی رباتها به این فایلها را با دستور Disallow محدود کنید.

۳. افزودن نقشه سایت (Sitemap) به robots.txt

برای اطمینان از اینکه گوگل و سایر موتورهای جستجو بهطور کامل و صحیح سایت شما را بخزند و ایندکس کنند، باید آدرس نقشه سایت (Sitemap) را در فایل robots.txt ذکر کنید. اگر از افزونه Yoast SEO استفاده میکنید، این افزونه بهطور خودکار نقشه سایت را به فایل robots.txt اضافه میکند، اما در صورتی که نقشه سایت در این فایل موجود نبود، میتوانید آن را بهصورت دستی اضافه کنید:

makefileCopyEditUser-agent: *Disallow:Sitemap: http://www.example.com/post-sitemap.xmlSitemap: http://www.example.com/page-sitemap.xml

این دستور به رباتهای جستجو اجازه میدهد تا به تمام سایت شما دسترسی داشته باشند و همچنین آدرس نقشه سایت را معرفی میکند تا موتورهای جستجو بتوانند صفحات را بهدرستی ایندکس کنند.

کلام آخر

فایل robots.txt در واقع ارتباط مستقیم شما با رباتهای موتورهای جستجو است و به آنها میگوید که کدام بخشهای سایت شما باید ایندکس شوند و کدام قسمتها باید از دسترس آنها پنهان بمانند. استفاده هوشمندانه از این فایل میتواند تأثیر زیادی بر سئو، بهینهسازی منابع سرور و همچنین مدیریت نمایش محتوای سایت شما در نتایج جستجو داشته باشد.

سوالات متداول درباره فایل Robots.txt

1. فایل robots.txt چیست و چرا به آن نیاز داریم؟

فایل robots.txt یک فایل متنی است که به موتورهای جستجو (رباتها) دستور میدهد که کدام بخشهای سایت باید خزش (Crawl) شوند و کدام بخشها باید از دید آنها مخفی بمانند. این فایل برای مدیریت دسترسی رباتها به سایت و جلوگیری از ایندکس شدن صفحات غیرضروری یا حساس استفاده میشود.

2. چگونه میتوانم فایل robots.txt خود را پیدا کنم یا ویرایش کنم؟

برای دسترسی به فایل robots.txt، کافی است آدرس دامنه سایت را در مرورگر وارد کرده و “/robots.txt” را به انتهای آن اضافه کنید. برای ویرایش این فایل، باید به هاست سایت خود وارد شده و فایل robots.txt را در دایرکتوری اصلی (Root Directory) پیدا کنید. سپس میتوانید تغییرات لازم را اعمال کرده و فایل را ذخیره کنید.

3. آیا باید تمام صفحات سایت را در فایل robots.txt مسدود کنم؟

نه، تنها صفحاتی که نمیخواهید موتورهای جستجو به آنها دسترسی داشته باشند باید در فایل robots.txt مسدود شوند. برای مثال، صفحات غیرضروری یا اطلاعات حساس مانند صفحات ورود و ثبتنام یا فایلهای خاص مانند تصاویر و PDF ها را میتوانید مسدود کنید. مهم است که مطمئن شوید صفحات اصلی و مهم سایت مسدود نشده باشند، زیرا این صفحات باید در نتایج جستجو ایندکس شوند.

4. آیا میتوانم نقشه سایت را در فایل robots.txt قرار دهم؟

بله، شما میتوانید آدرس نقشه سایت (Sitemap) خود را در فایل robots.txt قرار دهید تا موتورهای جستجو به راحتی صفحات سایت را پیدا کرده و ایندکس کنند. این کار باعث میشود موتورهای جستجو بهتر بتوانند ساختار سایت شما را درک کنند و صفحات جدید را سریعتر شناسایی کنند.